目录

01 Moshi

02 背后技术揭秘

GPT-4o可能要等到今年秋季才会公开。

然而,由法国8人团队开发的原生多模态Moshi,已经达到了接近GPT-4o的水平,现场演示几乎没有延迟,吸引了大量AI专家的关注。

令人惊讶的是,开源版的GPT-4o来得如此之快!

01 Moshi

昨晚,来自法国AI实验室kyutai的团队展示了首个实时原生多模态Moshi,效果媲美5月发布的GPT-4o。

例如,在一个演示中,Moshi作为助手帮助Alexa小哥进行太空探索,让人仿佛置身《流浪地球》中的Moss情景。

没体验过OpenAI最新版GPT-4o?快戳最详细升级教程,几分钟搞定:

升级ChatGPT-4o Turbo步骤![]() https://www.zhihu.com/pin/1768399982598909952

https://www.zhihu.com/pin/1768399982598909952

如何使用WildCard正确方式打开GPT-4o,目前 WildCard 支持的服务非常齐全,可以说是应有尽有!

官网有更详细介绍:WildCard

值得注意的是,这个由8人团队在仅仅半年的时间里,从零开始完成了模型的训练。

Moshi目前处于实验原型阶段,设计目的是理解和表达情感,支持听、说、看三种功能,并能够用70种不同的情绪和风格说话,甚至随时打断。

其最突出的能力是可以同时处理两个音频流,实现“听”和“说”同步进行。

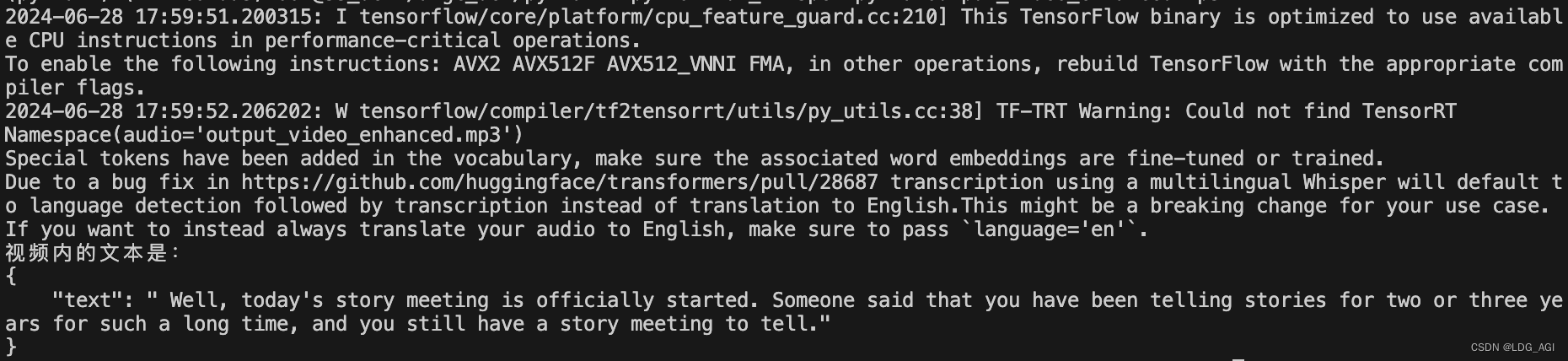

这种实时互动的实现基于文本和音频混合的联合预训练,使用Helium中的合成文本数据,训练出70亿参数的模型。

Moshi的端到端延迟最低可达160ms。最小版本的Moshi还可以在笔记本电脑或消费级GPU上运行。

许多人认为这是最接近GPT-4o的模型,Moshi的惊艳表现赢得了LeCun、Karpathy等AI大佬的转发。

Moshi这个名字来源于日语中的“もしもし”(接电话时的问候语)。接下来,Patrick邀请了四位同事上台展示Moshi的强大语音能力。

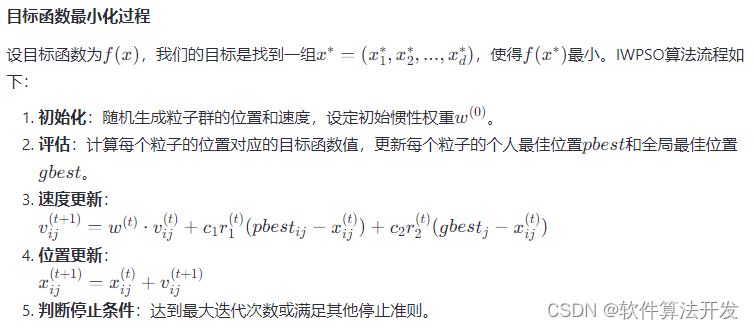

02 背后技术揭秘

Moshi在技术上有哪些创新,才能具备对标GPT-4o的实力?随后,同事们介绍了当前语音AI的一些限制,例如“听”使用自动语音识别技术,“想”使用大模型,“说”使用文本-语音技术。

这些分门别类的技术会导致语音AI出现较多延迟。

他认为,最明显的事实是——GPT-4o的语音功能尚未推出,而Moshi已在发布后上线。

此外,他还提到了几个值得关注的技术要点:

- 像kyutai这样的小型团队在6个月内构建出Moshi,表明其训练流程和架构非常简单且具有巨大的可扩展性,合成数据也起到了重要作用。

- Moshi专注于本地设备的部署,这将使其迅速流行并无处不在。相比之下,像GPT这样的模型由于盈利需求,不太可能推动本地运行。

- 在保持答案质量达到Llama 8B或以上水平的同时,将延迟降低到300ms以下是实现互动的关键因素。

那么,如何将这些步骤整合到单一的语音模型中呢?这正是kyutai的目标所在。

多模态Moshi不仅能够听和说,同时在语音输出时进行思考。

理论上,Moshi可以实现最低延迟为160毫秒,创造了世界新纪录。

该模型采用了I/O双通道系统,同时生成文本token和音频编解码器。

具体而言,语言模型Helium-7B首先进行从头训练,然后与文本和语音编码器联合训练。

语音编解码器基于Kyutai内部的Mimi模型,具有高达300倍的压缩系数,能够捕捉语义和声学信息。

在Moshi的微调过程中,采用了涉及100k个"口语式"合成对话的高度详细的文本记录,这些记录带有情感和风格注释,均由Helium模型转录而来。

此外,模型的语音训练还使用了另一个独立的TTS模型生成的合成数据。

模型还利用专业配音演员Alice录制了20小时的音频,并基于此进行微调。

研究人员指出,Moshi设计具有适应性,只需不到30分钟的音频即可完成微调。

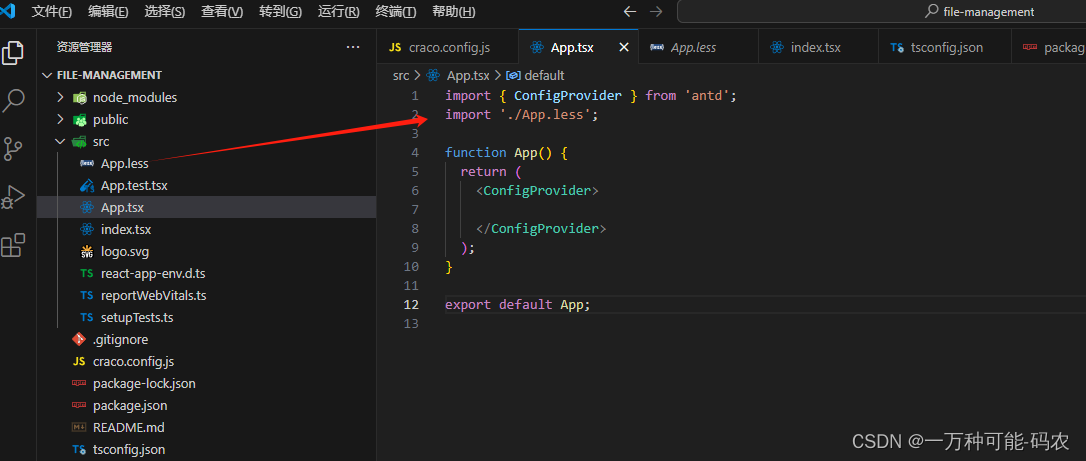

在部署方面,Moshi托管在Scaleway和抱抱脸上,能够处理两个批次大小为24 GB VRAM的任务。

此外,它还支持多种后端,包括CUDA、KV缓存,并能通过Rust优化推理代码。

为确保音频安全性,Kyutai将为生成的音频加上水印,并在数据库中对其进行索引。

如何使用WildCard正确方式打开GPT-4o,目前 WildCard 支持的服务非常齐全,可以说是应有尽有!

官网有更详细介绍:WildCard

推荐阅读:

GPT-4o不仅能写代码,还能自查Bug,程序员替代进程再进一步!

GPT-4替代大学生参加考试,94%成功作弊未被发现!

CTO透露GPT-5内幕,OpenAI 以36亿美元收购数据库初创公司